|

|

|

|

|

|

コンピュータの耳を創る |

|

◆高速・高精度な話し言葉音声認識技術 |

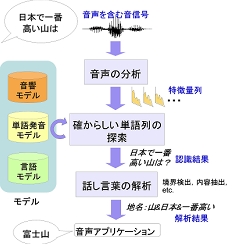

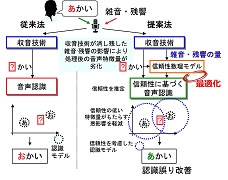

音声認識は「コンピュータの耳」に当る技術です。人間にとって最も基本的な情報伝達手段である音声を、コンピュータが自在に聞き取れるようにすることが私たちの目標です。音声認識は入力された音信号から音声区間を特定した後、有効な特徴を抽出し、予め学習・蓄積された、音声の特徴に関する知識(モデル)を用いて、入力音声に最も適合する単語の列を探し当てること(探索)で実現されます。音声は、たとえ同じ発話内容でも、話者や周囲の音環境等の違いにより、異なる音信号として観測されます。また、日常会話に現れるような話し言葉において、音声の振る舞いは、より多様化し、伝達される情報の曖昧性・不完全性も増していきます。人間は無意識に、このような多様性を巧みに吸収し、曖昧性・不完全性を補いながら音声を聞き取っているのです。そんな人間の耳に匹敵する認識能力をコンピュータ上に実現すべく、私たちは研究を進めています。

|

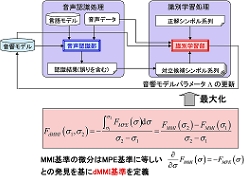

*1 differenced Maximum Mutual Information *2 Round Robin Duel Discrimination *3 Weighted Finite-State Transducer |

【参考文献】 |

[1] T. Hori, C. Hori, Y. Minami, and A. Nakamura, "Efficient WFST-based

one-pass decoding with on-the-fly hypothesis rescoring in extremely

large vocabulary continuous speech recognition," IEEE Transactions on

Audio, Speech and Language Processing, Vol. 15, pp. 1352―1365, 2007.

|

[2] M. Delcroix, T. Nakatani, and S. Watanabe, "Static and dynamic variance

compensation for recognition of reverberant speech with dereverberation

preprocessing," IEEE Transactions on Audio, Speech, and Language

Processing, vol. 17, no. 2, pp. 324-334, 2009.

|

[3] E. McDermott, S. Watanabe, and A. Nakamura, "Discriminative training

based on an integrated view of MPE and MMI in margin and error space,"

Proc. ICASSP'10, pp. 4894-4897, 2010.

|

[4] T. Hori, S. Araki, T. Yoshioka, M. Fujimoto, S. Watanabe, T. Oba, A.

Ogawa, K. Otsuka, D. Mikami, K. Kinoshita, T. Nakatani, A. Nakamura, J.

Yamato, "Low-latency real-time meeting recognition and understanding using

distant microphones and omni-directional camera," IEEE Transactions on

Audio, Speech, and Language Processing, Vol. 20, No. 2, pp. 499―513, 2012.

|

[5] T. Oba, T. Hori, A. Nakamura, A. Ito, "Round-Robin Duel Discriminative

Language Models," IEEE Transactions on Audio, Speech and Language

Processing, Vol. 20, No. 4, pp. 1244-1255, May 2012.

|

[6] Y. Kubo, S. Watanabe, T. Hori, A. Nakamura, "Structural Classification

Methods based on Weighted Finite-State Transducers for Automatic Speech

Recognition," IEEE Transactions on Audio, Speech, and Language

Processing, Vol. 20, Issue 8, pp. 2240―2251, 2012.

|

[7] M. Delcroix, K. Kinoshita, T. Nakatani, S. Araki, A. Ogawa, T. Hori,

S. Watanabe, M. Fujimoto, T. Yoshioka, T. Oba, Y. Kubo, M. Souden, S.-J.

Hahm, and A. Nakamura, "Speech recognition in living rooms:

Integrated speech enhancement and recognition system based on spatial,

spectral & temporal modeling of sounds," Computer

Speech and Language, Elsevier, vol. 27, no. 3, pp. 851-873, 2013.

|

[8] Y. Kubo, T. Hori, A. Nakamura, "Large Vocabulary Continuous Speech

Recognition Based on WFST Structured Classifiers and Deep Bottleneck

Features," Proc. ICASSP, 2013.

|

[9] M. Delcroix, S. Watanabe, T. Nakatani, and A. Nakamura,

"Cluster-based dynamic variance adaptation for interconnecting speech

enhancement pre-processor and speech recognizer," Computer Speech and

Language, Elsevier, vol. 27, no. 1, pp. 350-368, 2013.

|

[10] 堀 貴明,荒木 章子,久保 陽太郎,小川 厚徳,大庭 隆伸,中村 篤,

"自然な会話を聞き取る音声認識技術", 日経エレクトロニクス, 2013年10月号, pp.

71―81

|

[11] T. Hori, Y. Kubo, A. Nakamura, "Real-time one-pass decoding with

recurrent neural network language model for speech recognition," in

Proc. ICASSP, 2014.

|

|

|

|

|

Copyright (C) NTT Communication Science Laboratories |