English version (NEW)

(OLD)

NEWS

●

(学会企画)人工知能学会全国大会(2023年6月)でAffective Computingのオーガナイズドセッション(4回目)を企画中です。

●

(国際会議開催) Int'l Conf. Affective Computing & Intelligent Interaction

(ACII 2022)をGeneral Chairの一人として奈良&オンラインで開催しました。日本初開催となり盛況のもと終わりました。ご投稿・ご参加頂いた皆様有難うございました!

●

(著書) 主観感情推定に関して書いた概説記事2本が出版されました。まず、人工知能からの視点からの「主観感情推定の研究動向」が

人工知能学会誌にてAffective Computing特集に掲載されました。

他方、この一部をもっと心理学と絡めた内容がエモーション・スタディーズに掲載されています。

この辺りについて特に日本語の文献は希少ですので、お知りになりたい方の参考になれば幸いです。

●

(ポスドク募集)NTT コミュニケーション科学基礎研究所ではResearch associate (RA)を常時若干名募集しております。興味をお持ちの方はこちらをご覧の上ご連絡下さい。

●

(博士後期課程学生募集) 筑波大学 理工情報生命学術院 システム情報工学研究群 知能機能システム学位プログラム (IMIS)にて博士後期課程学生を若干名募集しております。Affective Computing、特に感情・情動の計算論的モデル化・推定に興味のある修士学生の方は上記IEEEアカウントまでメールください。使うデータも主観、行動、生理の単体、統合どちらも可です。専攻は不問で興味とやる気次第です。ただし、何らかの数理統計に慣れていればより進めやすいと思われます。例えば、ベイズ理論といった(心理)統計学や機械学習(深層学習、強化学習、メタ学習)などが挙げられます。博士前期課程については今のところ直接の学生受入は行っておりません。学部4年生または修士学生で興味をお持ちの方はまず夏か冬のNTT研究所インターンシップにお越し頂くとよいかもしれません。

●

[終了] (学会企画)人工知能学会全国大会(2021年6月)でAffective Computingのオーガナイズドセッションを開催しました。ご発表・ご参加頂いた皆様ありがとうございました。

●

[終了] (インターン生募集)2021/8-9月の間で2021年度夏期実習生を募集しています。興味をお持ちの大学院生(M/D不問)の方はNTT研究所インターントップまたは私まで直接ご連絡下さい。(マッチングあり)→終了しました。沢山のご応募ありがとうございました。次は2021年度冬期(2022年1-3月の間)を予定しております。

●

[終了] (学会企画・登壇)人工知能学会全国大会@熊本(2020年6月)でAffective Computingのオーガナイズドセッションを開催します。企画セッション「感情とAI」にも登壇予定です。

●

[終了] IROS 2019 full-day workshop "Machines with Emotions"(2019/11/4@Macau)にて登壇します。詳細はWorkshop HPを随時ご確認下さい。

●

[終了] 日本感情心理学会 第27回大会 プレカンファレンス(2019/6/28@名古屋)にて登壇します。詳細は大会HPを随時ご確認下さい。

→多くの皆様のご参加有難うございました。

●

[終了]

ACII 2019 (Int'l Conf. Affective Computing & Intelligent Interaction

にて"Culture- and Gender-originated affect"と題したSpecial Sessionを企画しました

(Organizers: Prof. Ohkura, Kumano, Prof. Rau, Prof. Berque)。

投稿期限を過ぎました。ご投稿有難うございました。

●

[終了] 日本心理学会第82回大会(2018年9月25-27日@仙台)にて

村田藍子氏(代表者)とともに開催した公開シンポジウム

『「場」の共有が生み出す情動の伝染・変化:評価と介入の有機的連携に向けて』

が終わりました。多くの皆様のご参加有難うございました。

●

[終了] 第13回日本感性工学会春季大会

(2018年3月27日(火)〜28日(水)@名古屋大学)にてAffective Computingセッションを開催しました。

詳しくはこちら。

研究内容

人の気持ちが他者にどのように伝わるか(共感)を、数理的なモデル化、特に個人のモデル化を通じて科学的に明らかにしようとしています。それにより、人の心を理解でき、人と気持ちが通じあえる機械の実現につながることが期待されます。計算機科学と心理学を両学問の本質を捉えつつ融合することで、(1)革新的技術を生み出しながら、(2)新たな心理学的発見につなげることを目指しています。ベイズ統計を柱として、Affective Computing(感情計算論)、機械学習、コンピュータビジョン、認知科学、計量心理学、心理統計など複数の分野が関連しますので、各分野の専門家との連携も大事にしています。

情動認知や評定過程のモデル化 (Affective Computing/Science, Cognitive Science)

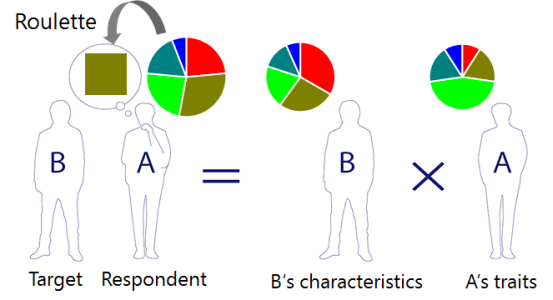

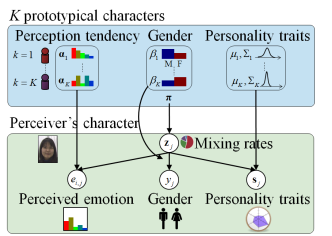

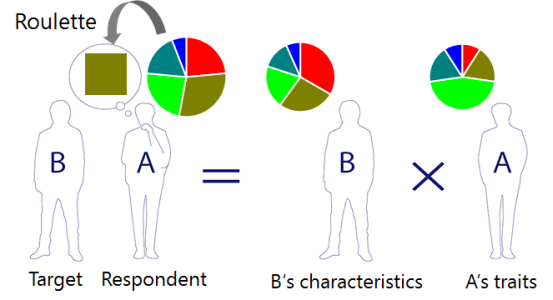

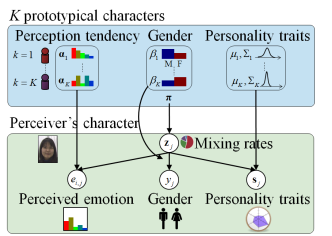

個人の認知モデルの構築

ある特定の個人がある特定の対象に対してどう認知(評定)するのかのモデルをベイズ理論をもとに構築しています。統計的機械学習と心理統計学/計量心理学などを融合させる研究です。

|

|

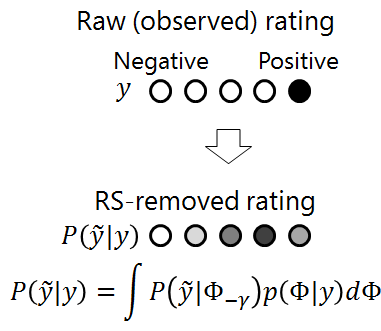

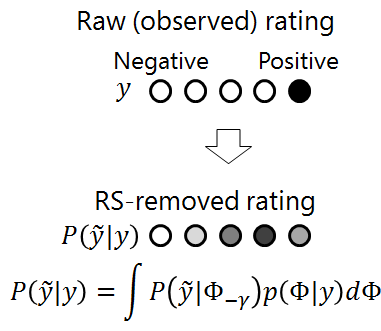

評定値からの回答スタイルの除去

主観評定は依然重要な測定法の一つですが、評定者の極端反応傾向/中心反応傾向といった回答スタイルにより歪めらます。その成分を推定・除去することで,その人の真の評価を浮き上がらせることを目指します。

|

|

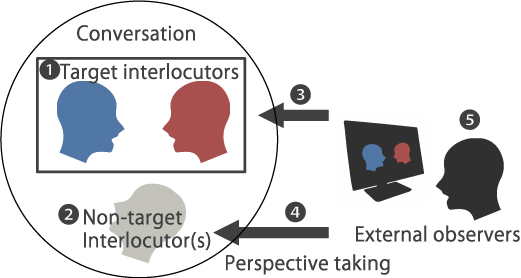

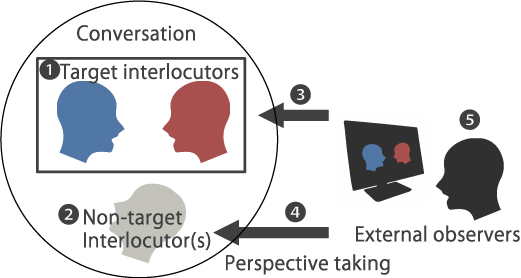

視点による評定の違いの分析

情動状態に関する主観評定が、本人(たち)、対話内の他者、対話を外から見る評定者の間でどう異なるかを調べています。複数の人の評定を集約した集合知の精度も検証しています。(一部、東大との共同研究)

|

[ACII 2017a] etc.

|

|

[ACII 2019] etc.

|

|

Illustrated by K. Nomura.

[ACII 2017a, CogSci 2019] etc.

|

|

|

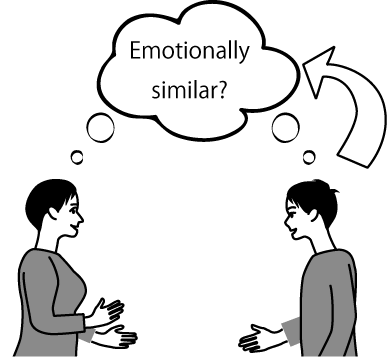

共感の数理モデル化 (Affective Computing/Science, Cognitive Science)

共感の認知モデル

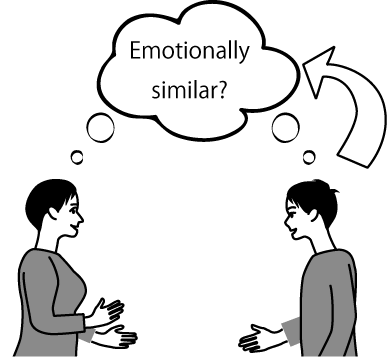

情動的共感の一過程である「二人の情動の類似」に着目し,どのような人が他者と似た情動になりやすく、また、似た情動になっていることを正しく認知しやすいかを類似性判断理論などの理論にもとづき調べています。

|

|

特定個人の認知傾向のモデル化

ある人がどのような認知の傾向を持っているかを,性別や性格特性から予想します.

これにより,この人はこのように認知しやすい,という傾向が推定できます.

|

|

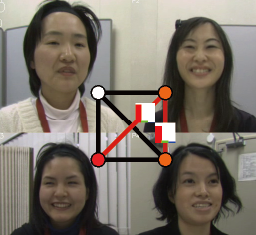

共感状態のモデル化・自動推定

対話している各二人が共感しているのかを他者がどのように感じるかを,被評価者たちの視線,表情,発話の有無等の組み合わせパターンから予想します.

|

[IJAE 2019, IEICE Trans. 2020] etc.

|

|

[ACII 2013] etc.

|

|

[IEEE TAC 2015] etc.

|

|

|

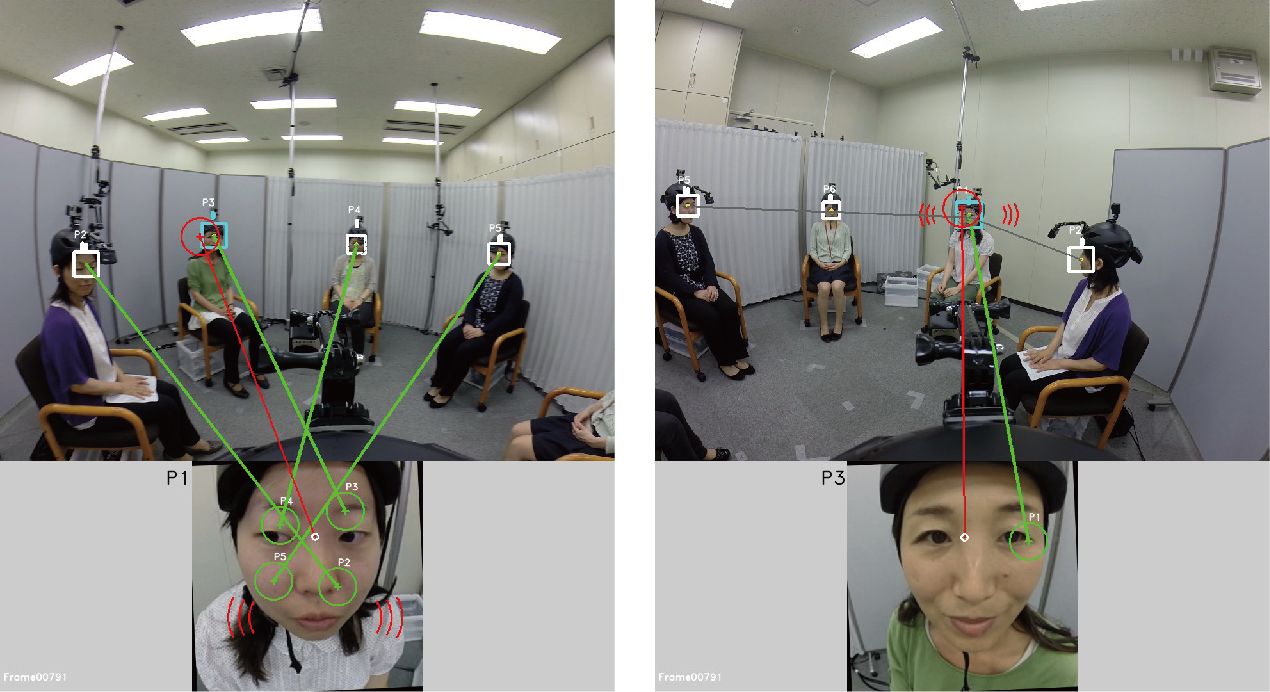

対人行動の自動計測や可視化 (Computer Vision, Affective Computing)

学会活動

学会/会議運営

Int'l Conf. Affective Computing and Intelligent Interaction,

(ACII 2021 & ACII 2022, General Co-Chair), (ACII 2019, Industry & Sponsorship Co-Chair)

IAPR Int'l Conf. on Machine Vision Applications (MVA 2013-2015), Organizing Committee Member

2021/04- JSAI SIG-SLUD 言語・音声理解と対話処理研究会 幹事

2018/06- 電子情報通信学会 ヒューマンコミュニケーション基礎(HCS)研究会 専門委員

2009/04-2013/03 情報処理学会コンピュータビジョンとイメージメディア研究会 運営委員

セッション等の企画

2020年度,2021年度 人工知能学会全国大会,

オーガナイズドセッション「Affective Computing」,筆頭企画者

Int'l Conf. Affective Computing & Intelligent Interaction (ACII 2019),

"Culture- and Gender-originated affect",

Organizers: Michiko Ohkura, Shiro Kumano, Patrick Rau, Dave Berque

日本心理学会第82回大会(2018年9月),

公開シンポジウム 『「場」の共有が生み出す情動の伝染・変化:評価と介入の有機的連携に向けて』,

村田藍子(企画代表者),熊野史朗(企画者)

第13回日本感性工学会春季大会(2018),

企画セッション「Affective Computing(感情計算論)」, 企画者

シニアプログラム委員等

ACM Int'l Conf. Multimodal Interaction (ICMI 2018,2020), Senior Program Committee Member

Int'l Conf. Affective Computing and Intelligent Interaction (ACII 2017, 2019), Senior Program Committee Member

AAAI Conference on Artificial Intelligence (AAAI 2022), Senior Program Committee Member

プログラム委員/査読

IEEE Trans. Affective Computing (TAC), Reviewer

IEEE Trans. Circuits and Systems for Video Technology (TCSVT), Reviewer

Machine Vision and Applications, Reviewer

IEICE Trans, Reviewer

IEEE Conf. Computer Vision and Pattern Recognition (CVPR 2013-), Program Committee Member

IEEE Int'l Conf. Computer Vision (ICCV 2013-), Program Committee Member

European Conf. Computer Vision (ECCV 2016-), Program Committee Member

Asian Conf. Computer Vision (ACCV 2014-), Program Committee Member

British Machine Vision Conference (BMVC 2017-), Program Committee Member

ACM Int'l Conf. Multimedia (ACM MM 2014), Program Committee Member

IEEE Int'l Conf. Automatic Face and Gesture Recognition (FG 2011-), Program Committee Member

Int'l Conf. Pattern Recognition (ICPR 2010-), Reviewer

IEEE Int'l Conf. Acoustics, Speech, and Signal Processing (ICASSP 2014), Reviewer

Int'l Audio/Visual Mapping Personality Traits Challenge & Workshop (MAPTRAITS'14), Technical Program Committee Member

The first Int'l Workshop Affective Analysis in Multimedia (AAM 2013), Technical Program Committee Member

Int'l Conf. Informatics, Electronics & Vision 2012 (ICIEV 2012-14), International Program Committee Member

The 15th Int'l Multimedia Modeling Conference (MMM 2009), Reviewer

業績

表彰等

Outstanding Paper Award, Int'l Conf. Multimodal Interaction (ICMI 2014)

Honorable Mention Award, Asian Conference on Computer Vision (ACCV 2007)

ヒューマンコミュニケーション賞(HC賞),電子情報通信学会 ヒューマンコミュニケーショングループ, 2014

優秀インタラクティブ発表賞, HCGシンポジウム2012, 2015x2

オーガナイズドセッション賞, HCGシンポジウム2015, 2018

インタラクティブセッション賞, 画像の認識・理解シンポジウム (MIRU2011)

平成21年度 日本学生支援機構 奨学金返還免除

招待講演

[3] Shiro Kumano,

"Machine Reading People’s Subjective Evaluation from Their Self-Reports and Facial Expression", IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2019) Workshop Machines with Emotions, 2019.

[2] Shiro Kumano,

"Computational Model for Inferring How an Individual Perceives Others' Affective States,"

Lectures, Swiss Center for Affective Sciences, 2017.

[1] 熊野 史朗,

「対話中に生じる二者間の共感に関する観察者認知の確率モデルと自動推定」,

電子情報通信学会ヴァーバル・ノンヴァーバル・コミュニケーション(VNV)研究会,2014.

会議での登壇(話題提供者等)

[3] 熊野史朗,話題提供, 「個人差多次元尺度構成法にもとづく二者情動一致のベイズ認知モデル」,日本感情心理学会第27回大会,プレカンファレンス1「顔・表情が伝えるもの」(企画者:難波修史先生),2019.

[2] 熊野史朗, 話題提供, "Can we change how people read other’s mind, and measure its effects? -A study on modeling perspective taking effects -,"

日本心理学会第82回大会

公募シンポジウム『「場」の共有が生み出す情動の伝染・変化:評価と介入の有機的連携に向けて』(代表企画者:村田藍子, 企画者:熊野史朗), 2018.

[1] 熊野史朗,話題提供, 「本人・相手・第三者による情動一致の認知と機械によるその自動予測」, 第13回日本感性工学会春季大会, 企画セッション Affective Computing(感情計算論)(企画者:熊野史朗),2018.

査読付き論文誌

[25]

Shiro Kumano, Antonia Hamilton and Bahador Bahrami,

"The role of anticipated regret in choosing for others",

Scientific Reports,

11, Article No. 12557, 2021.

[24]

Aiko Murata, Keishi Nomura, Junji Watanabe and Shiro Kumano,

"Interpersonal physiological synchrony is associated with first person and third person subjective assessments of excitement during cooperative joint tasks",

Scientific Reports,

11, Article No. 12543, 2021.

[23]

Takayuki Ogasawara, Hanako Fukamachi, Kenryu Aoyagi, Shiro Kumano, Hiroyoshi Togo and Koichiro Oka,

"Archery Skill Assessment Using an Acceleration Sensor"

IEEE Trans. Human-Machine Systems (THMS),

vol. 51, no. 3, pp. 221-228, 2021.

[22]

石井 亮, 大塚 和弘, 熊野 史朗,東中 竜一郎,青野 裕司,

「話者継続・交替時における対話行為と視線行動に基づく共感スキルの推定」,

情報処理学会論文誌,Vol. 62, No. 1, pp. 100-114, 2021.

[特選論文]

[21]

アンタケ チャダーポーン 玲羅, 村田 藍子, 熊野 史朗,

「個人差多次元尺度構成法にもとづく二者情動一致判断のベイズ認知モデル」,

電子情報通信学会論文誌, Vol. J103-D, No.03, pp. 102-110, Mar. 2020.

[20]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Ryuichiro Higashinaka, and Junji Tomita,

"Prediction of Who Will Be Next Speaker and When Using Mouth-Opening Pattern in Multi-Party Conversation"

Multimodal Technologies Interact.,

No. 3, Vol. 4, 2019.

[19]

石井 亮, 熊野 史朗, 大塚 和弘, 「話者継続・交替時における参与役割に応じた視線行動に基づく共感スキルの推定」, ヒューマンインタフェース学会論文誌, No. 20, Vol. 4, pp. 447-456, 2018.

[18]

Li Li, Shiro Kumano (equally contributed first author), Anita Keshmirian, Bahador Bahrami, Jian Li and Nicholas D. Wright,

"Parsing cultural impacts on regret and risk in Iran, China and the United Kingdom",

Scientific Reports, Vol. 8, 13862, 2018.

[17]

Layla Chadaporn Antaket, Masafumi Matsuda, Kazuhiro Otsuka and Shiro Kumano,

"Analyzing Generation and Cognition of Emotional Congruence using Empathizing-Systemizing Quotient",

International Journal of Affective Engineering,

Vol.17 No.3, pp. 183-192, 2018.

[free download from publisher's site]

[16]

Shiro Kumano, Kazuhiro Otsuka, Ryo Ishii, and Junji Yamato,

"Collective First-Person Vision for Automatic Gaze Analysis in Multiparty Conversations,"

IEEE Trans. Multimedia,

Vol. 19, Issue 1, pp. 107-122, 2017.

[pdf]

[15]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Junji Yamato,

"Using Respiration of Who Will be the Next Speaker and When in Multiparty Meetings",

ACM Trans. Interactive Intelligent Systems (TiiS),

Vol. 6, Issue 2, Article No. 20, 2016.

[14]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Junji Yamato,

"Prediction of Who Will be the Next Speaker and When using Gaze Behavior in Multi-Party Meetings",

ACM Trans. Interactive Intelligent Systems (TiiS),

Vol. 6, Issue 1, No. 4, 2016.

[13]

石井亮,大塚和弘,熊野史朗,大和淳司,

「複数人対話における頭部運動に基づく次話者の予測」

情報処理学会論文誌,

Vol. 57, No. 4, pp. 1116-1127, 2016.

[12]

Dairazalia Sanchez-Cortes, Shiro Kumano, Kazuhiro Otsuka, Daniel Gatica-Perez,

"In the Mood for Vlog: Multimodal Inference in Conversational Social Video,"

ACM Trans. Interactive Intelligent Systems (TiiS), Vol. 5, No. 2, 9:1-24, 2015.

[11]

Shiro Kumano, Kazuhiro Otsuka, Dan Mikami, Masafumi Matsuda, and Junji Yamato,

"Analyzing Interpersonal Empathy via Collective Impressions,"

IEEE Trans. Affective Computing,

Vol. 6, Issue 4, pp. 324-336, 2015.

[pdf]

[10]

Shiro Kumano, Kazuhiro Otsuka, Masafumi Matsuda, and Junji Yamato,

"Analyzing Perceived Empathy Based on Reaction Time in Behavioral Mimicry,"

IEICE Trans. on Information and System, Vol. E97-D, No. 8, pp. 2008-2020, 2014.

[pdf]

[9]

石井亮,大塚和弘,熊野史朗,松田昌史,大和淳司,「複数人対話における注視遷移パターンに基づく次話者と発話開始タイミングの予測」,電子情報通信学会論文誌,

Vol. J97-A, No. 6, 2014.

[8]

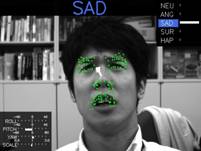

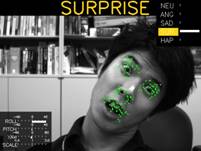

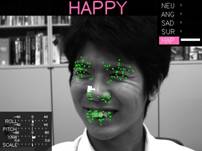

Shiro Kumano, Kazuhiro Otsuka, Junji Yamato, Eisaku Maeda and Yoichi Sato, "Pose-Invariant Facial Expression Recognition Using Variable-Intensity

Templates",

International Journal of Computer Vision,

Vol. 83, no. 2, pp.178-194, 2009.

[pdf]

[7]

松田昌史,八重樫海人,大坊郁夫,熊野史朗,大塚和弘,大和淳司,

「ビデオ通信環境における対人位置と印象形成に関する探索的研究」,

ヒューマンインタフェース学会誌, Vol. 15, No. 4, pp. 433-442, 2013.

[6]

大塚和弘,熊野史朗,松田昌史,大和淳司,

「MM-Space:頭部運動の物理的補強表現に基づく会話場再構成」,

情報処理学会論文誌,Vol. 54,No. 4,pp. 1450-1461,2013.

[5]

Dan Mikami, Kazuhiro Otsuka, Shiro Kumano, and Junji Yamato,

"Enhancing Memory-based Particle Filter with Detection-based Memory Acquisition for Robustness under Severe Occlusion,"

IEICE Trans. on Information and System, Vol. E95-D, No.11, 2012.

[4]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一,

「パーティクルフィルタとこう配法の組み合わせによる頭部姿勢と表情の同時推定」,

電子情報通信学会論文誌 D, Vol. J92-D, No. 8, pp.1349-1362, 2009.

[3]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一

「変動輝度テンプレートによる頭部姿勢と表情の同時推定」,

情報処理学会論文誌コンピュータビジョンとイメージメディア,

Vol. 1, No. 2, pp.50-60, 2008.

[2]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一,

「変動輝度テンプレートを用いた頭部姿勢変動に頑健な確率的表情認識手法」,

情報科学技術レターズ, pp.215-218, 2007.

[1]

熊野史朗, 藤野陽三, 阿部雅人, 吉田純司, 松崎拓也,

「膜の動的変形を対象とした画像計測システムの構築」,

膜構造研究論文集, No.17, pp.7-13, 2003.

国際会議

[42] Hiromi Narimatsu, Ryo Ueda and Shiro Kumano,

"Cross-Linguistic Study on Affective Impression and Language for Visual Art Using Neural Speaker,"

in Proc. International Conference on Affective Computing & Intelligent Interaction (ACII 2022), 2022.

[41] Katsutoshi Masai, Monica Perusquia-Hernandez, Maki Sugimoto, Shiro Kumano and Toshitaka Kimura,

"Consistent Smile Intensity Estimation From Wearable Optical Sensors,"

in Proc. International Conference on Affective Computing & Intelligent Interaction (ACII 2022), 2022.

[40] Takayuki Ogasawara, Hanako Fukamachi, Kenryu Aoyagi, Shiro Kumano, Hiroyoshi Togo and Koichiro Oka,

"Real-time Auditory Feedback System for Bow-tilt Correction while Aiming in Archery,"

in Proc. 22nd IEEE International Conference on BioInformatics and BioEngineering (BIBE2022), 2022.

[39] Keishi Nomura, Shiro Kumano and Kensuke Okada,

"A simple method for handling reflective invariance in Bayesian IRT,

in Proc. International Meeting of Psychometric Society (IMPS 2022), 2022.

[38] Yan Zhou, Tsukasa Ishigaki and Shiro Kumano,

"Deep Explanatory Polytomous Item-Response Model for Predicting Idiosyncratic Affective Ratings",

in Proc. International Conference on Affective Computing & Intelligent Interaction (ACII 2021), 2021. (Oral)

[pdf]

[37] Hiroyuki Ishihara and Shiro Kumano,

"Gravity-Direction-Aware Joint Inter-Device Matching and Temporal Alignment between Camera and Wearable Sensors",

in Proc. ICMI '20 Companion, 2020.

[36] Aiko Murata, Shiro Kumano and Junji Watanabe,

"Interpersonal physiological linkage is related to excitement during a joint task",

in Proc. Annual Meeting of the Cognitive Science Society (CogSci 2020), 2020.

[35] Shiro Kumano, Keishi Nomura,

"Multitask Item Response Models for Response Bias Removal from Affective Ratings,"

in Proc. International Conference on Affective Computing & Intelligent Interaction (ACII 2019), 2019. (Oral)

(Please access to the texts of this paper from the link here, since we found they cannot be read on IEEE Xplore-published version for any reasons.)

[34] Keishi Nomura, Shiro Kumano, Yuko Yotsumoto,

"Multitask Item Response Model Revealed Bias in Estimated Emotional Features due to Response Style within the Open Affective Standardized Image Set (OASIS)",

in Proc. The 52nd Annual Meeting of the Society for Mathematical Psychology (MathPsych 2019), 2019.

[33] Keishi Nomura, Aiko Murata, Yuko Yotsumoto, Shiro Kumano,

"Bayesian Item Response Model with Condition-specific Parameters for Evaluating the Differential Effects of Perspective-taking on Emotional Sharing,"

in Proc. Annual Meeting of the Cognitive Science Society (CogSci 2019), 2019.

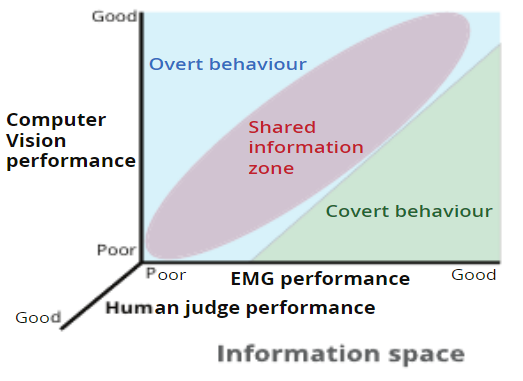

[32] M. Perusquia-Hernandez, S. Ayabe-Kanamura, K. Suzuki, S. Kumano,

"The Invisible Potential of Facial Elec-tromyography: a Comparison of EMG and Computer Vision when Distinguishing Posed from Spontaneous Smiles,"

in Proc. CHI Conf. Human Factors in Computing Systems (CHI 2019), Paper No. 149, 2019. (Full paper)

[31] Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Ryuichiro Higashinaka, and Junji Tomita,

"Analyzing Gaze Behavior and Dialogue Act during Turn-taking for Estimating Empathy Skill Level,"

in Proc. ACM Int'l Conf. Multimodal Interaction (ICMI), 2018.

[30] Ryo Ishii, Shiro Kumano, Kazuhiro Otsuka,

"Analyzing Gaze Behavior during Turn-taking for Estimating Empathy Skill Level,"

In Proc. ACM Int'l Conf. Multimodal Interaction (ICMI), 2017.

[29] Shiro Kumano, Ryo Ishii, Kazuhiro Otsuka,

"Computational Model of Idiosyncratic Perception of Others' Emotions,"

In Proc. Int'l Conf. Affective Computing and Intelligent Interaction (ACII 2017),

pp. 42-49, 2017.

[pdf]

[28] Shiro Kumano, Ryo Ishii, Kazuhiro Otsuka,

"Comparing Empathy Perceived by Interlocutors in Multiparty Conversation and External Observers,"

In Proc. Int'l Conf. Affective Computing and Intelligent Interaction (ACII 2017),

pp. 50-57, 2017.

[27] Ryo Ishii, Shiro Kumano, Kazuhiro Otsuka,

"Prediction of Next-Utterance Timing using Head Movement in Multi-Party Meetings,"

In Proc. Int'l Conf. Human-Agent Interaction (HAI2017).

[26] Ryo Ishii, Shiro Kumano, Kazuhiro Otsuka,

"Analyzing Mouth-Opening Transition Pattern for Predicting Next Speaker in Multi-party Meetings",

In Proc. ACM Int'l Conf. Multimodal Interaction (ICMI), 2016.

[25] Ryo Ishii, Shiro Kumano, Kazuhiro Otsuka,

"Multimodal Fusion using Respiration and Gaze for Predicting Next Speaker in Multi-party Meetings",

In Proc. ACM Int'l Conf. Multimodal Interaction (ICMI), pp. 99-106, 2015.

[24]

Shiro Kumano, Kazuhiro Otsuka, Ryo Ishii, Junji Yamato,

"Automatic Gaze Analysis in Multiparty Conversations

based on Collective First-Person Vision,"

In Proc. International Workshop on Emotion Representation, Analysis and Synthesis in Continuous Time and Space (EmoSPACE).

pp. 1-8, vol. 5, 2015.

[pdf]

[23] Ryo Ishii, Shiro Kumano, Kazuhiro Otsuka,

"Predicting Next Speaker using Head Movement in Multi-party Meetings",

In Proc. IEEE Int'l Conf. Acoustics, Speech, and Signal Processing (ICASSP),

pp. 2319-2323, 2015.

[22]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Junji Yamato,

"Analysis of Respiration for Prediction of Who Will Be Next Speaker and When? in Multi-Party Meetings,"

In Proc. Int'l Conf. Multimodal Interaction (ICMI), 2014.

[Outstanding Paper Award]

[21]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Junji Yamato,

"Analysis of Timing Structure of Eye Contact in Turn-changing,"

In Proc. ACM Workshop on Eye Gaze in Intelligent Human Machine Interaction, 2014.

[20]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Junji Yamato,

"Analysis and Modeling of Next Speaking Start Timing based on Gaze Behavior in Multi-party Meetings",

In Proc. IEEE Int'l Conf. on Acoustics, Speech, and Signal Processing (ICASSP 2014), 2014.

[19]

Kazuhiro Otsuka, Shiro Kumano, Ryo Ishii, Maja Zbogar, Junji Yamato,

"MM+Space: n x 4 Degree-of-Freedom Kinetic Display for Recreating Multiparty Conversation Spaces", In Proc. International Conference on Multimodal Interaction (ICMI 2013), 2013.

[18]

Ryo Ishii, Kazuhiro Otsuka, Shiro Kumano, Masafumi Matsuda, Junji Yamato,

"Predicting Next Speaker and Timing from Gaze Transition Patterns in Multi-Party Meetings",

In Proc. International Conference on Multimodal Interaction (ICMI 2013), 2013.

[17]

Dairazalia Sanchez-Cortes, Joan-Isaac Biel, Shiro Kumano, Junji Yamato, Kazuhiro Otsuka and Daniel Gatica-Perez,

"Inferring Mood in Ubiquitous Conversational Video",

In Proc. Int'l Conf. on Mobile and Ubiquitous Multimedia (MUM2013), 2013.

[16]

S. Kumano, K. Otsuka, M. Matsuda, R. Ishii, J. Yamato,

"Using A Probabilistic Topic Model to Link Observers' Perception Tendency to Personality",

In Proc. Humaine Association Conference on Affective Computing and

Intelligent Interaction (ACII), pp. 588-593, 2013.

[pdf]

[15]

S. Kumano, K. Otsuka, M. Matsuda, J. Yamato,

"Analyzing perceived empathy/antipathy based on reaction time in behavioral coordination",

In Proc. International Workshop on Emotion Representation, Analysis and Synthesis in Continuous Time and Space (EmoSPACE), 2013.

[pdf]

[14]

S. Kumano, K. Otsuka, D. Mikami, M. Matsuda and J. Yamato,

"Understanding Communicative Emotions from Collective External Observations",

In Proc. CHI '12 extended abstracts on Human factors in computing systems (CHI2012),

pp. 2201-2206, 2012.

[pdf]

[13]

Kazuhiro Otsuka, Shiro Kumano, Dan Mikami, Masafumi Matsuda, and Junji Yamato, “Reconstructing Multiparty Conversation Field by Augmenting Human Head Motions via Dynamic Displays", In Proc. CHI '12 extended abstracts on Human factors in computing systems (CHI ’12), 2012.

[12]

Dan Mikami, Kazuhiro Otsuka, Shiro Kumano, and Junji Yamato, Enhancing Memory-based Particle Filter with Detection-based Memory Acquisition for Robustness under Severe Occlusions,

In Proc. VISAPP2012, 2012.

[11]

Kazuhiro Otsuka, Kamil Sebastian Mucha, Shiro Kumano, Dan Mikami,,Masafumi Matsuda, and Junji Yamato, "A System for Reconstructing Multiparty Conversation Field based on Augmented Head Motion by Dynamic Projection",

In Proc. ACM Multimedia 2011, 2011.

[10] L. Su, S. Kumano, K. Otsuka, D. Mikami, J. Yamato, and Y. Sato,

"Early Facial Expression Recognition with High-frame Rate 3D Sensing",

In Proc. IEEE Int’l Conf. Systems, Man, and Cybernetics (SMC 2011),

Oct., 2011.

[9] Takashi Ichihara, Shiro Kumano, Daisuke Yamaguchi, Yoichi Sato, Yoshihiro Suda, Li Shuguang,

"Evaluation of eco-driving skill using traffic signals status information",

In Proc. ITS World Congress (ITSWC2010), 2010.

[8] Yoshihiro Suda, Katsushi Ikeuchi, Yoichi Sato, Daisuke Yamaguchi, Shintaro Ono, Kenichi Horiguchi, Shiro Kumano, Ayumi Han, Makoto Tamaki,

"Study on Driving Safety Using Driving Simulator",

In Proc. International Symposium on Future Active Safety Technology (FAST-zero’11), 2011.

[7]

S. Kumano, K. Otsuka, D. Mikami and J. Yamato,

"Analyzing Empathetic Interactions based on the Probabilistic Modeling of the Co-occurrence Patterns of Facial Expressions in Group Meetings",

In Proc. IEEE International Conference on Automatic Face and Gesture Recognition (FG 2011),

pp. 43-50, 2011.

[pdf]

[6] Takashi Ichihara, Shiro Kumano, Daisuke Yamaguchi, Yoichi Sato and Yoshihiro Suda,

"Driver assistance system for eco-driving",

In Proc. ITS World Congress 2009, 2009.

[5] Shiro Kumano, Kenichi Horiguchi, Daisuke Yamaguchi, Yoichi Sato, Yoshihiro Suda and Takahiro Suzuki,

"Distinguishing driver intentions in visual distractions",

In Proc. ITS World Congress 2009, 2009.

[4]

S. Kumano, K. Otsuka, D. Mikami and J. Yamato,

"Recognizing Communicative Facial Expressions for Discovering Interpersonal Emotions in Group Meetings",

In Proc. International Conference on Multimodal Interfaces (ICMI),

Sept. 2009.

[pdf],

[poster]

[3]

S. Kumano, K. Otsuka, J. Yamato, E. Maeda and Y. Sato, "Combining Stochastic

and Deterministic Search for Pose-Invariant Facial Expression Recognition",

In Proc. British Machine Vision Conference (BMVC), 2008.

[2]

S. Kumano, K. Otsuka, J. Yamato, E. Maeda and Y. Sato, "Pose-Invariant Facial

Expression Recognition Using Variable-Intensity Templates",

In Proc. Asian Conference on Computer Vision (ACCV), Vol. I, pp.324-334, 2007.

[Honorable mention Award]

[1] Junji Yoshida, Masato Abe, Shiro Kumano, and Yozo Fujino,

"Construction of A Measurement System for the Dynamic Behaviors of Membrane by Using Image Processing",

In Proc. Structural Membrane 2003 - International Conference on Textile Composites and Inflatable Structures, 2003.

国内会議・研究会等

[34]

熊野 史朗, 野村 圭史,

「情動評定値からの回答スタイル除去法」,

人工知能学会全国大会論文集, 2020.

[33]

熊野 史朗, 野村 圭史,

「情動評定値からの回答スタイル除去」,

電子情報通信学会HCGシンポジウム,2019.

[32]

アンタケ チャダーポーン 玲羅, 熊野 史朗,

「個人差多次元尺度構成法にもとづく二者情動一致のベイズ認知モデル」,

電子情報通信学会HCGシンポジウム,HCG2018-A-4-6,2018.

[31]

石井亮, 大塚和弘, 熊野史朗, 東中竜一郎, 富田準二,

「話者継続・交替時の視線行動と対話行為に基づく共感スキルの推定」,

電子情報通信学会HCGシンポジウム,HCG2018-B-3-4,2018.

[オーガナイズドセッション賞受賞]

[30]

Layla C. Antaket, Masafumi Matsuda, Kazuhiro Otsuka, and Shiro Kumano,

"Analyzing Generation and Cognition of Emotional Congruence using Empathizing-Systemizing Quotient",

第13回日本感性工学会春季大会, 査読セッション, WG1-1, 2018.

[29]

熊野史朗,

「本人・相手・第三者による情動一致の認知と機械によるその自動予測」,

第13回日本感性工学会春季大会,

企画セッション Affective Computing(感情計算論),

2018. (原稿無し)

[28]

アンタケチャダポーン玲羅,松田昌史,大塚和弘,熊野史朗,

「二者情動一致の認知モデルの提案,および,心理特性との関連分析」,

電子情報通信学会HCGシンポジウム,HCG2017-A-1-3,2017.

[27]

熊野史朗,石井亮,大塚和弘,

「三者間共感理論における本人・傍参与者・外部観察者による評定の違いの分析」,

電子情報通信学会 ヒューマンコミュニケーション基礎(HCS)研究会,

vol. 117,pp. 13-18,2017.

[26]

石井亮,熊野史朗,大塚和弘,

「話者継続・交替時の視線行動に基づく共感スキルの推定」,

電子情報通信学会 ヒューマンコミュニケーション基礎(HCS)研究会,

vol. 117,pp. 19-24,2017.

[25]

熊野史朗,石井亮,大塚和弘,

「評定者個人に特化した他者感情理解モデル」,

人工知能学会全国大会,2H4-OS-35b-3in2, 2017.

[24]

熊野史朗,大塚和弘,石井亮,大和淳司,

「集団的一人称視点映像解析に基づく複数人対話の自動視線分析」,

電子情報通信学会HCGシンポジウム,

pp. 319-326, 2015.

[優秀インタラクティブ発表賞受賞]

[オーガナイズドセッション賞受賞]

[23]

石井亮,熊野史朗,大塚和弘,

「複数人対話における視線と呼吸動作に基づく次話者予測」,電子情報通信学会HCGシンポジウム,

pp. 20-26, 2015.

[優秀インタラクティブ発表賞受賞]

[22]

石井亮, 大塚和弘, 熊野史朗, 大和淳司,

「複数人対話での視線交差のタイミング構造に基づく次話者と発話開始タイミングの予測」,

人工知能 学会全国大会,2015.

[21]

石井亮, 大塚和弘, 熊野史朗, 大和淳司,

「複数人対話での話者交替に関する頭部動作の分析 〜次話者と発話開始タイミングの予測モデルの構築に向けて〜」,

電子情報通信学会HCGシンポジウム,2014.

[20]

石井亮,大塚和弘,熊野史朗,大和淳司,

「複数人対話での話者交替に関する呼吸動作の分析 〜次話者と発話開始タイミングの予測モデルの構築に向けて〜」,

電子情報通信学会,ヒューマンコミュニケーション基礎研究会,

vol.114, no.189, HCS2014-49, pp.35-40,2014.

[電子情報通信学会ヒューマンコミュニケーション賞]

[19]

熊野史朗,大塚和弘,松田昌史,石井亮,大和淳司,

「確率的トピックモデルによる対人認知傾向と性格特性の関連付け」,

情報処理学会第76回全国大会,2014.

[18]

石井亮, 大塚和弘, 熊野史朗, 松田 昌史, 大和 淳司,

「複数人対話における注視遷移パターンに基づく次話者と発話開始タイミングの予測」,

人工知能学会,SLUD研究会,2013.

[17]

武田十季,熊野史朗,小笠原隆行,小林稔,浦哲也,定方徹,田中智博,

「コミュニケーション活性化のための感情状態のランク付けに基づく体験記録提示インタフェースの提案と評価」,信学技報,vol. 113,no. 185,HCS2013-42,pp. 51-56,2013.

[16]

武田十季, 浦哲也, 熊野史朗, 小笠原隆行, 西田京介, 定方徹, 小林稔,

「体験記録のハイライトに向けた体験時の感情状態の分析」, 電子情報通信学会技術研究報告(MVE), 2013.

[15]

武田十季, 浦哲也, 熊野史朗, 小笠原隆行, 西田京介, 定方徹, 小林稔,

「感情変化に着目した振り返り・共有を促す体験記録ハイライトの提案」,データ工学と情報マネジメントに関するフォーラム(DEIM),2013.

[14]

松田昌史,本間元康,熊野史朗,石井亮,大塚和弘,大和淳司,「視線一致範囲測定に関す

る探索的検討 −疎らな実験データの解析−」,電子情報通信学会技術研究報告, 112(455),

173-178, 2013.

[13]

松田昌史,本間元康,熊野史朗,石井亮,大塚和弘,大和淳司,「アイコンタクト知覚範囲

の性差に関する探索的検討 −社交性不安およびアイコンタクト相手の性別の影響−」,電子

情報通信学会技術研究報告, 112(412), 77-82, 2013.

[12]

熊野史朗, 大塚和弘, 松田昌史, 大和淳司,

「二者間の行動の一致性と時間差に基づく外部観察者の共感解釈の分析」,

HCGシンポジウム, 2012.

[優秀インタラクティブ発表賞受賞]

[11]

松田昌史,本間元康,熊野史朗,石井亮,大塚和弘,大和淳司,「アイコンタクト知覚体積の規定因に関する探索的研究」,日本社会心理学会大会発表論文集, 2012.

[10]

大塚和弘,熊野史朗,三上弾,松田昌史,大和淳司:「MM-Space:動的投影を用いた頭部運動の物理的補強表現に基づく会話場再構成」,インタラクション2012.

[9]

松田昌史, 八重樫海人, 大坊郁夫, 三上弾, 熊野史朗, 大塚和弘, 大和淳司, ビデオ通信環境における対人印象に関する探索的研究 ―当事者評価と傍観者評価の比較―, 電子情報通信学会技術研究報告, 111(393), 27-32, 2012.

[8]

松田昌史, 八重樫海人, 大坊郁夫, 三上弾, 熊野史朗, 大塚和弘, 大和淳司, ビデオ通信環境における対人印象の規定因に関する探索的実験研究 ―第三者に対する映像呈示と音声呈示の比較―, 電子情報通信学会技術研究報告, 111(464), 49-54, 2012.

[7]

熊野史朗, 大塚和弘, 三上弾, 大和淳司,

「複数人対話を対象とした表情と視線に基づく共感/反感の推定モデルとその評価」,

電子情報通信学会技術報告,ヒューマンコミュニケーション基礎研究会 (HCS)(フォーラム顔学2011共催, HCSジョイントセッション), HCS 111(214), pp. 33-38,2011.

[6]

熊野史朗, 大塚和弘, 三上弾, 大和淳司,

「複数人対話を対象とした顔表情の共起パターンの確率モデルに基づく共感状態の推定」,

画像の認識・理解シンポジウム(MIRU), 2011.

[インタラクティブセッション賞受賞]

[5]

D. Mikami, K. Otsuka, S. Kumano, and J. Yamato,

"Enhancing Memory-based Particle Filter with Detection-based Memory Acquisition for Robustness under Severe Occlusions",

画像の認識・理解シンポジウム(MIRU2011), 2011.

[4]

L. Su, S. Kumano, K. Otsuka, D. Mikami, J. Yamato, E. Maeda, Y. Sato,

"Subtle Facial Expression Recognition Based on Expression Category-dependent Motion Magnification",

情報科学技術フォーラム(FIT), 2010.

[3]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一

「パーティクルフィルタと勾配法の組み合わせによる頭部姿勢変動に頑健な表情認識手法」,

画像の認識・理解シンポジウム(MIRU), 2008.

[2]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一

「変動輝度テンプレートを用いた頭部姿勢変動に頑健な表情認識手法」,

画像の認識・理解シンポジウム(MIRU), 2007.

[1]

熊野史朗, 大塚和弘, 大和淳司, 前田英作, 佐藤洋一

「表情認識のための変動輝度テンプレートとその頭部姿勢変動に対する頑健性の一検討」,

コンピュータビジョンとイメージメディア研究報告, Vol. 2007, No. 87, pp.145-152, 2007.

![]()