聞きたい人の声に耳を傾けるAI

深層学習に基づく音声の選択的聴取技術SpeakerBeam

メディア情報研究部 信号処理研究グループ

マーク デルクロア

マーク デルクロア

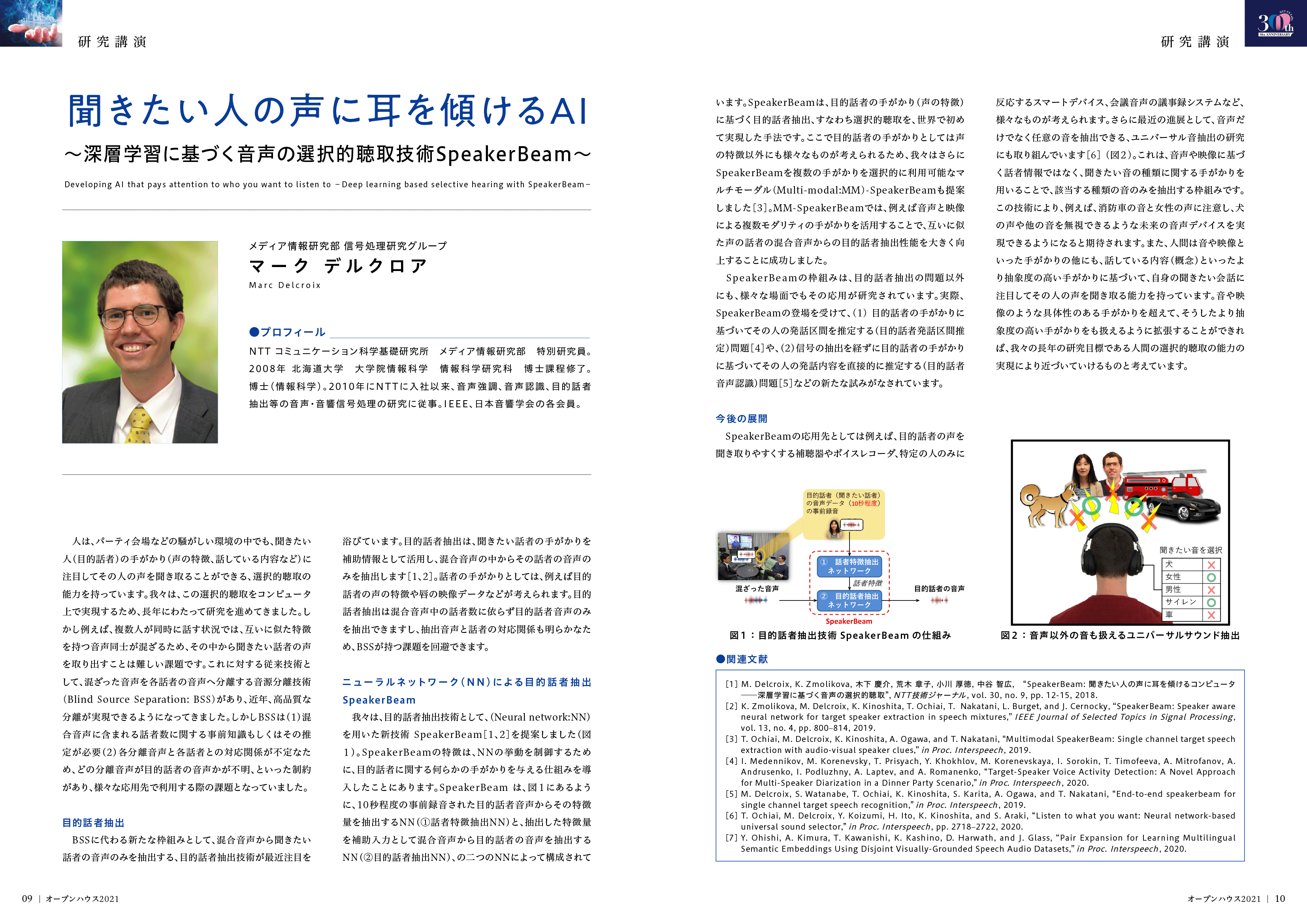

人は、パーティ会場などの騒がしい環境の中でも、聞きたい人(目的話者)の手がかり(声の特徴など)に注目してその人の声を聞き取ることができる、「選択的聴取」と呼ばれる能力を持っています。本講演では、この選択的聴取をコンピュータで実現することをめざした研究をご紹介します。はじめに、我々が提案した、目的話者の手がかりに基づき混ざった音声の中から目的話者の音声のみを抽出する技術SpeakerBeamについてご紹介します。さらに、音声や唇の形状など、音や映像などの複数のモダリティを使うマルチモーダル目的話者手がかりへの拡張や音声認識との統合、音響イベント信号を含んだより一般的な信号抽出問題への拡張といった最新の研究動向についてもご紹介する予定です。

関連文献

[1] M. Delcroix, K. Zmolikova, 木下慶介, 荒木章子, 小川厚徳, 中谷智広, “SpeakerBeam: 聞きたい人の声に耳を傾けるコンピュータ──深層学習に基づく音声の選択的聴取”, NTT技術ジャーナル, Vol. 30, No. 9, pp. 12-15, 2018.

[2] K. Zmolikova, M. Delcroix, K. Kinoshita, T. Ochiai, T. Nakatani, L. Burget, and J. Cernocky, “SpeakerBeam: Speaker aware neural network for target speaker extraction in speech mixtures,” IEEE Journal of Selected Topics in Signal Processing, Vol. 13, No. 4, pp. 800–814, 2019.

[3] T. Ochiai, M. Delcroix, K. Kinoshita, A. Ogawa, and T. Nakatani, “Multimodal SpeakerBeam: Single channel target speech extraction with audio-visual speaker clues,” in Proc. The 20th Annual Conference of the International Speech Communication Association(INTERSPEECH), pp. 2718-2722, 2019.

[4] I. Medennikov, M. Korenevsky, T. Prisyach, Y. Khokhlov, M. Korenevskaya, I. Sorokin, T. Timofeeva, A. Mitrofanov, A. Andrusenko, I. Podluzhny, A. Laptev, A. Romanenko, “Target-Speaker Voice Activity Detection: A Novel Approach for Multi-Speaker Diarization in a Dinner Party Scenario,” in Proc. The 21th Annual Conference of the International Speech Communication Association(INTERSPEECH), pp. 274-278, 2020.

[5] M. Delcroix, S. Watanabe, T. Ochiai, K. Kinoshita, S. Karita,A. Ogawa, and T. Nakatani, “End-to-end speakerbeam for single channel target speech recognition,” in Proc. The 20th Annual Conference of the International Speech Communication Association(INTERSPEECH), pp. 451-455, 2019.

[6] T. Ochiai, M. Delcroix, Y. Koizumi, H. Ito, K. Kinoshita, and S. Araki, “Listen to what you want: Neural network-based universal sound selector,” in Proc. The 21th Annual Conference of the International Speech Communication Association(INTERSPEECH), pp. 2718–2722, 2020.

[7] Y. Ohishi, A. Kimura, T. Kawanishi, K. Kashino, D. Harwath, J. Glass, “Pair Expansion for Learning Multilingual Semantic Embeddings Using Disjoint Visually-Grounded Speech Audio Datasets,” in Proc. The 21th Annual Conference of the International Speech Communication Association(INTERSPEECH), pp. 1486-1490, 2020.

マーク デルクロア

NTTコミュニケーション科学基礎研究所 メディア情報研究部 特別研究員。2008年 北海道大学 大学院情報科学 情報科学研究科 博士課程修了。博士(情報科学)。2010年にNTTに入社以来、音声強調、音声認識、目的話者抽出等の音声・音響信号処理の研究に従事。IEEE、日本音響学会の各会員。