・誰が話をしているのか?

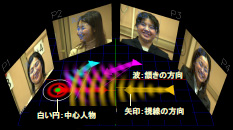

・誰が誰を見ているのか?

・誰が誰に向かって話し掛けているのか?誰が誰の話を聞いているのか?

・誰が誰に反応しているのか?

・誰が誰に強い影響を与えているのか? 誰が誰から強い影響を受けているのか?

などです。これらは人間にとっては、いとも簡単な事ですので、コンピュータにとっても簡単なタスクのように思えますが、実はそう簡単なものではありません。現在はこれら低次の情報の推定しかできませんが、将来的には、「誰が彼を怒らせたのか?」「何故、彼女は泣いているのか?」などより高次の人間のコミュニケーションが理解できるコンピュータの実現を目指しています。こうした技術は、会議の自動議事録の作成、遠隔地間の会議を効率的に進めるため自動映像編集などへの応用が考えられる他、人間社会に参画できるロボットの構築にも不可欠なものとなると期待されています。

デモビデオ 再生

(再生時間 約3分50秒、サイズ 約62.1MB)

S. Araki, M. Fujimoto, K. Ishizuka, H. Sawada, and S. Makino, "Speaker Indexing and Speech Enhancement in Real Meetings / Conversations," ICASSP2008, pp.93--96, 2008. [PDF]

荒木, 藤本, 石塚, 澤田, 牧野, "音声区間検出と方向情報を用いた会議音声話者識別システムとその評価," 日本音響学会2008年春季研究発表会, 2008. [PDF]

Kazuhiro Otsuka, Hiroshi Sawada, and Junji Yamato, "Automatic Inference of Cross-modal Nonverbal Interactions in Multiparty Conversations", Proc. ACM 9th Int. Conf. Multimodal Interfaces (ICMI2007), pp. 255-262, Nov. 2007. [PDF]

大塚和弘, 竹前嘉修, 大和淳司, 村瀬 洋:「複数人物の対面会話を対象としたマルコフ切替モデルに基づく会話構造の確率的推論」, 情報処理学会論文誌,Vol. 47, No. 7, pp. 2317-2334, 2006. [Link]

Oscar Mateo Lozano and Kazuhiro Otsuka, “Simultaneous and Fast 3D Tracking of Multiple Faces in Video by GPU-based Stream Processing”, Proc. IEEE ICASSP2008 (The 33rd International Conference on Acoustics, Speech, and Signal Processing), pp.714--716, 2008. [PDF]

成果ビデオ 再生

(再生時間 約4分42秒、サイズ 約70.0MB)

M. Fujimoto, K. Ishizuka, and T. Nakatani, "A Voice Activity Detection Based on the Adaptive Integration of Multiple Speech Features and a Signal Decision Scheme," ICASSP2008, pp. 4441--4444, 2008. [PDF]

藤本 雅清, 石塚健太郎, 加藤 比呂子, "音声と雑音両方の状態遷移過程を有する雑音下音声区間検出," 情報処理学会研究報告, SLP-64-03, pp. 13-18, 2006. [Link]

K. Ishizuka and T. Nakatani, "Study of noise robust voice activity detection based on periodic component to aperiodic component ratio," SAPA2006, pp.65--70, 2006. [PDF]

"雑音に頑健な音声信号区間検出法" NTT先端技術総合研究所, News Letter, No.239. 2007. [PDF]

T. Yoshioka, T. Nakatani, T. Hikichi, and M. Miyoshi, "Maximum likelihood approach to speech enhancement for noisy reverberant signals," ICASSP 2008, pp. 4585-4588, 2008.

[PDF]

吉岡拓也, 中谷智広, 三好正人, "雑音と残響の同時抑圧による音声強調," 日本音響学会2008年春季研究発表会, pp. 731-732, 2008. [PDF]

木下慶介, 中谷智広, 澤田宏, 荒木章子, 三好正人, "複数音源が存在する残響環境でのマルチステップ線形予測の効果," 日本音響学会 2007年秋季研究発表会, pp. 731-732, 2007. [PDF]

This material is presented to ensure timely dissemination of scholarly and technical work. Copyright and all rights therein are retained by authors or by other copyright holders. All persons copying this information are expected to adhere to the terms and constraints invoked by each author's copyright. In most cases, these works may not be reposted without the explicit permission of the copyright holder.

(c)20xx IEEE. Personal use of this material is permitted. However, permission to reprint/republish this material for advertising or promotional purposes or for creating new collective works for resale or redistribution to servers or lists, or to reuse any copyrighted component of this work in other works must be obtained from the IEEE.