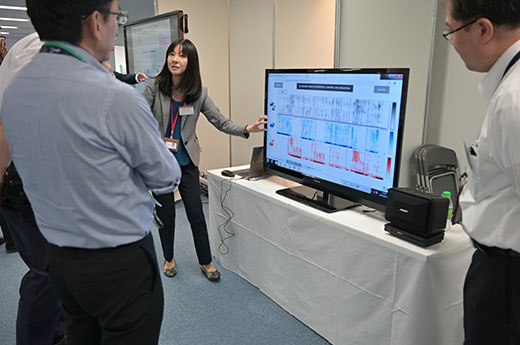

研究展示

メディアの科学

17

いつ、誰が、何を話した?全部で何人いた?

~何人の会話でも聞き分けられる深層学習モデル~

どんな研究

会話収録音から、「いつ、誰が、何を話したか」という情報を推定します。従来の類似技術は、収録状況に関して様々な条件(話者は移動不可、話者数は既知、等)を仮定し、その条件が満たされた時のみうまく動作するものでした。しかし、実データではこれらの条件が満たされないことも多々あります。

どこが凄い

提案法は、複数人の声が重なっていても、話者数を数え上げながら、「いつ、誰が話したか」という情報を、話者の声の特徴に基づき精度良く推定します。深層学習に基づく、任意の会話状況を表現できるモデルであり、適切な学習データがあれば、あらゆる実会話データに対応できることが期待されます。

めざす未来

人と人との会話から「いつ、誰が、何を話したか」という情報を自動獲得する技術は、会話を自動分析する技術の基盤となり、議事録自動作成や、私たちのコミュニケーションを助けるロボットの実現に寄与します。今後は、より実際的なデータを用い、提案原理の有効性を検証していきます。

関連文献

- [1] K. Kinoshita, L. Drude, M. Delcroix, T. Nakatani, “Listening to each speaker one by one with recurrent selective hearing networks,” in Proc. IEEE International Conference on Acoustics, Speech & Signal Processing (ICASSP), pp. 5064-5068, 2018.

- [2] T. von Neuman, K. Kinoshita, M. Delcroix, S. Araki, T. Nakatani, R. Haeb-Umbach, “All-neural online source separation, counting, and diarization for meeting analysis,” in Proc. IEEE International Conference on Acoustics, Speech & Signal Processing (ICASSP) , 2019. (to appear)

ポスター

PDFの表示にはAdobe Acrobat Reader等のPDF閲覧表示が必要です。

当日の様子

連絡先

木下 慶介(Keisuke Kinoshita) メディア情報研究部 信号処理研究グループ

Email:

Email: