研究展示

メディアの科学

20

声と画像から知らないモノを学びとるAI

~音声と画像によるクロスモーダル概念獲得~

どんな研究

AIがモノを認識するためには、モノの見え方とその言語表現(名前)を紐付けた辞書が必要です。この展示では、画像を説明する音声データだけから、モノが映る画像領域と声による言語表現を教師ラベルなしで対応付けて、AIが知らないモノを自ら学び取る(辞書を自動作成する)技術を紹介します。

どこが凄い

日本語音声データセットを新たに構築し、既存の英語/ヒンディ語音声と合わせて、画像との潜在空間を深層学習することで、従来よりも精度良く、画像領域と言語表現が紐付けられることを確認しました。この手法により、画像を通じて異なる言語の単語翻訳知識が学習されることも大きな特徴です。

めざす未来

TV放送のような世の中に多く存在するメディアデータを与えるだけで、AIが音と映像の共起(時空間的な偏り)を見つけながら自律的にモノやコトの概念を学び、賢くなる未来を目指しています。音や映像、言語を自在に横断する超大規模アーカイブ検索や自動アノテーションなどへの応用を検討しています。

関連文献

- [1] 大石康智, 木村昭悟, 川西隆仁, 柏野邦夫, D. Harwath, J. Glass, “画像を説明する多言語音声データを利用したクロスモーダル探索,” 電子情報通信 学会技術報告, パターン認識・メディア理解(PRMU)研究会, (to appear)

- [2] D. Harwath, G. Chuang, J. Glass, “Vision as an Interlingua: Learning Multilingual Semantic Embeddings of Untranscribed Speech,” in Proc. IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP2018), 2018.

ポスター

PDFの表示にはAdobe Acrobat Reader等のPDF閲覧表示が必要です。

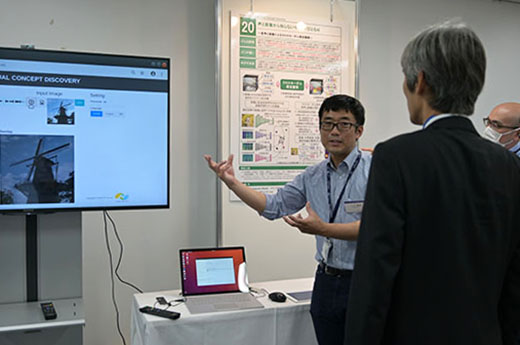

当日の様子

連絡先

大石 康智(Yasunori Ohishi) メディア情報研究部 メディア認識研究グループ

Email:

Email: