データと学習の科学

深層学習をモバイル向けに小さくします

~量子化による深層学習のモデル圧縮技術~

どんな研究

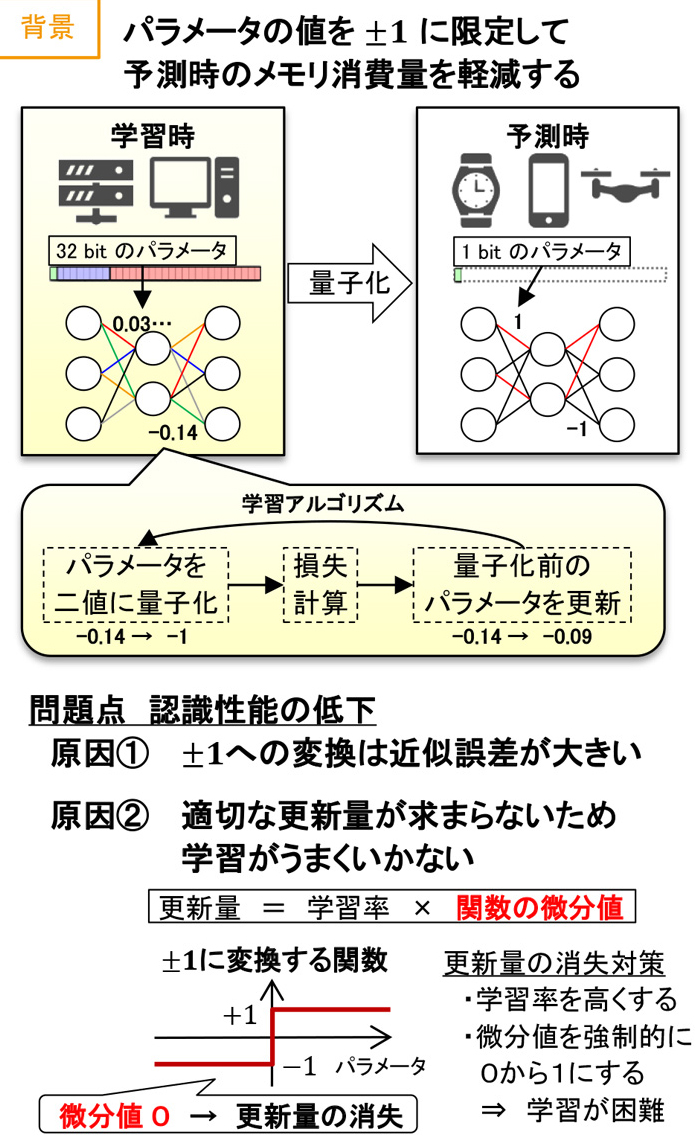

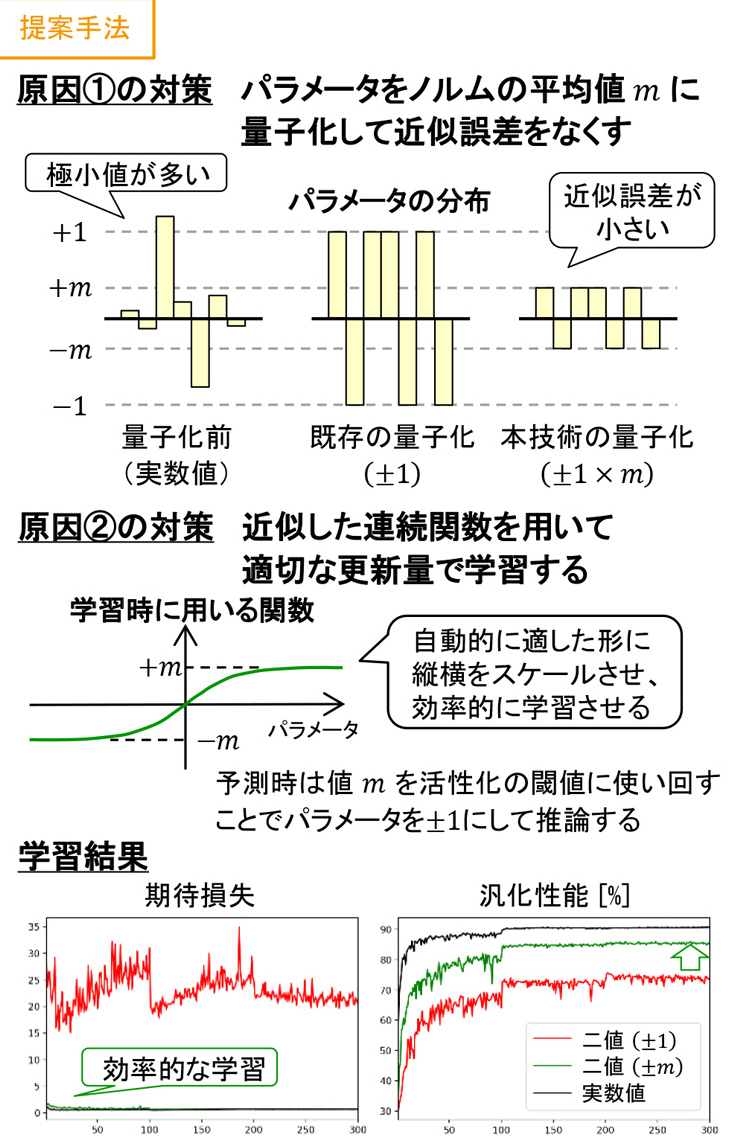

画像や音声などの認識に深層学習が盛んに用いられています。しかし、重みを保持するパラメータの数が多いため、メモリを大量に消費します。本研究ではパラメータの分布を考慮した新たな量子化により、深層学習のメモリ消費量を32分の1に低減できる学習法を提案します。

どこが凄い

深層学習の連続値であるパラメータを±1に限定する量子化の影響を最小限にすると同時に効率的な学習アルゴリズムとすることで、従来手法よりも高精度かつ高速な量子化が可能となります。また、学習後にはビット演算で計算できるため、高速に予測できるようになります。

めざす未来

本技術は要求性能の低い深層学習を作ります。そのため、パラメータが多いほど高精度な予測の行える深層学習を性能の低い小型端末上で動かせるようになります。これにより、これまで深層学習が使えなかった様々な端末で画像や音声などの高度な認識が行えるようになります。

関連文献

- [1] 大屋優, 井田安俊, 藤原靖宏, 岩村相哲, “正則化による深層学習の重み量子化手法の検討,” 電子情報通信学会技術研究報告, Vol. 117, No. 211, pp. 51-52, 2017.

[2] 大屋優, 井田安俊, 藤原靖宏, 岩村相哲, “バイナリニューラルネットにおける非活性化手法の検討,” 電子情報通信学会技術研究報告, Vol. 117, No. 238, pp. 119-120, 2017.

ポスター

PDFの表示にはAdobe Acrobat Reader等のPDF閲覧表示が必要です。

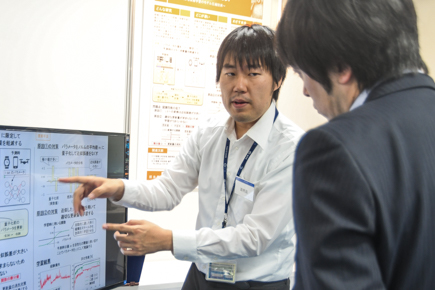

当日の様子

展示代表者

大屋 優

ソフトウェアイノベーションセンタ

ソフトウェアイノベーションセンタ