| 04 |

ニューラルネットを軽量・高速化する学習技術ニューラルネットの枝刈りにおける反復ランダム化技術

|

|---|

| どんな研究 |

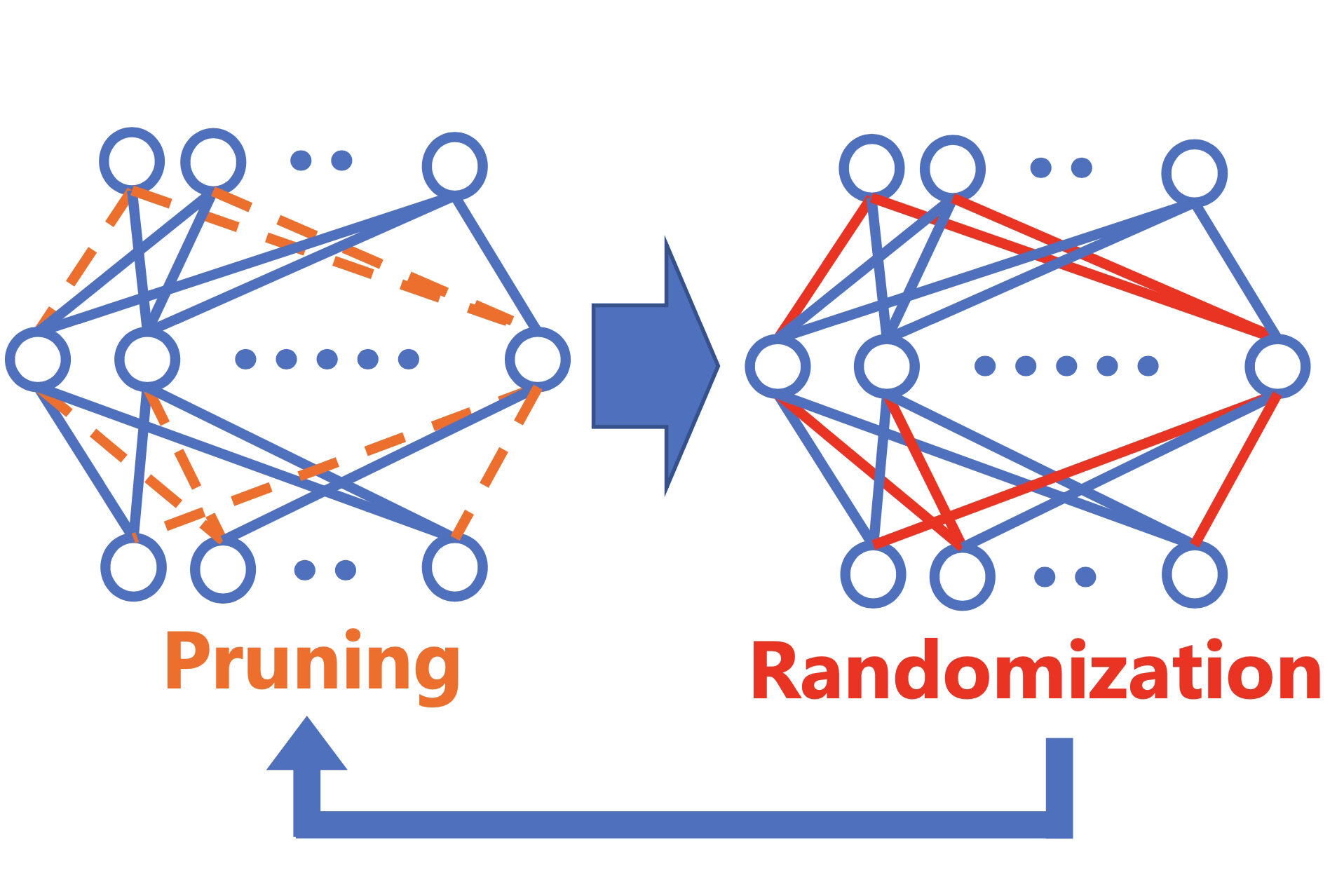

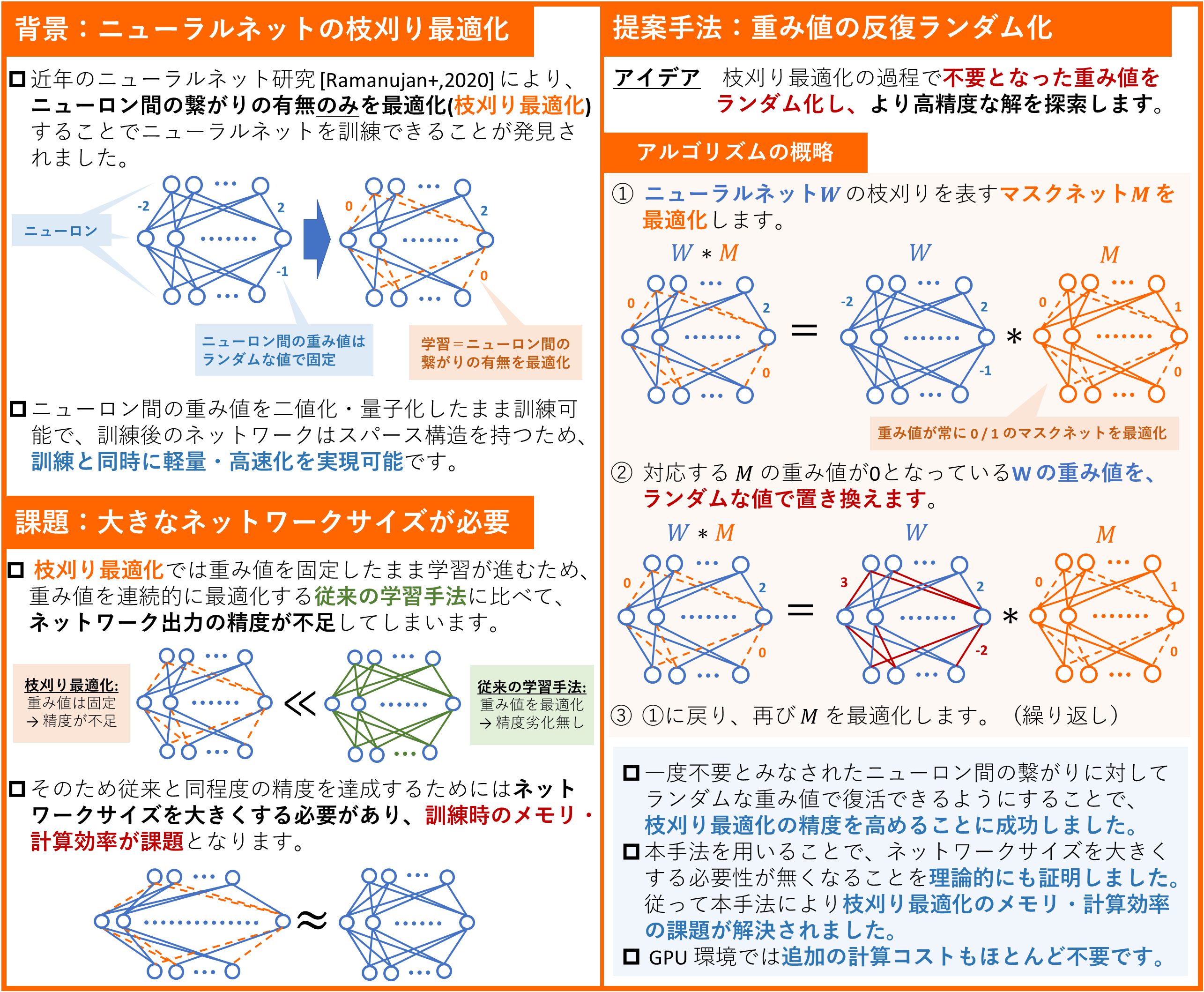

深層学習の新たな学習メカニズムとして枝刈り最適化が注目されています。枝刈り最適化で学習されたニューラルネットはスパース&軽量である一方、学習時に従来より大きなネットワークが必要なことが課題でした。本研究ではこの課題を解決する新たな原理を考案しました。 |

|---|---|

| どこが凄い |

枝刈り最適化が従来に比べて大きなネットワークを必要とすることは理論的にも証明されており、実用上の課題となっていました。本研究ではパラメータの反復ランダム化によりこの課題が解決されることを理論的に証明し、また画像・テキスト分類において実験的にも有効性を確認しました。 |

| めざす未来 |

近年の深層学習の大規模化に伴い、その運用コストやエネルギー消費量は無視できないものとなっています。本研究を発展させることで、ニューラルネットを更に軽量・高速化できる学習技術を実現し、AIの運用コスト削減や省エネルギー化に貢献することをめざします。 |

[1] D. Chijiwa, S. Yamaguchi, Y. Ida, K. Umakoshi, T. Inoue, “Pruning randomly initialized neural networks with iterative randomization,” Advances in Neural Information Processing Systems 34, 2021.

[2] V. Ramanujan, M. Wortsman, A. Kembhavi, A. Farhadi, M. Rastegari, “What's hidden in a randomly weighted neural network?,” in Proc. of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 11893?11902, 2020.

千々和 大輝 (Daiki Chijiwa) コンピュータ&データサイエンス研究所

Email: cs-openhouse-ml@hco.ntt.co.jp