研究展示

| 19 |

少ないデータから適切な表現を学習します複数タスクにおける表現学習のための事前知識の学習

|

|---|

| どんな研究 |

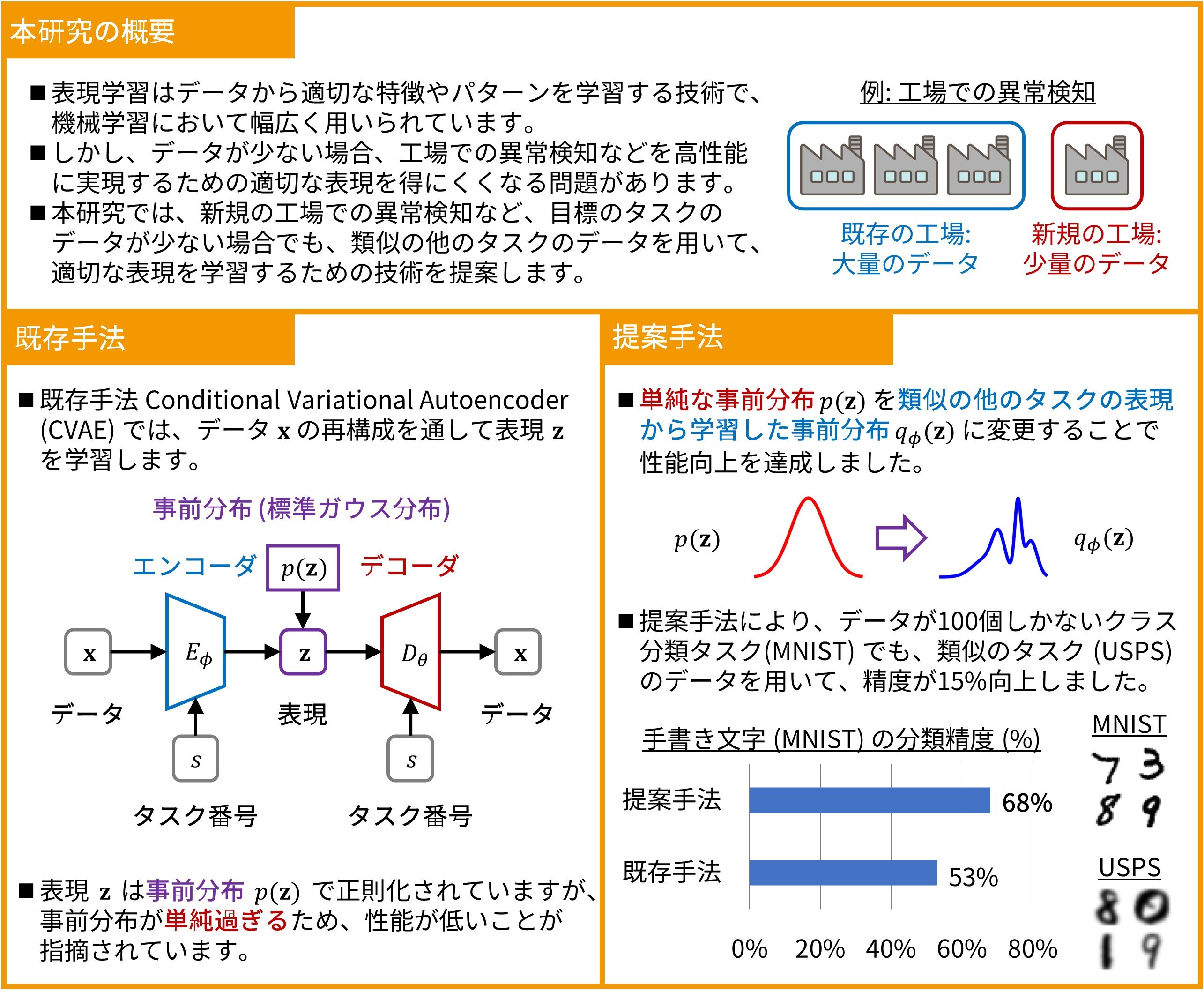

表現学習はデータから適切な特徴やパターンを学習する技術で、機械学習において幅広く用いられています。しかし、データが少ない時に性能が低下する問題があります。本展示は、データが少ない時でも、他のタスクのデータを用いることで、適切な表現を学習する技術を紹介します。 |

|---|---|

| どこが凄い |

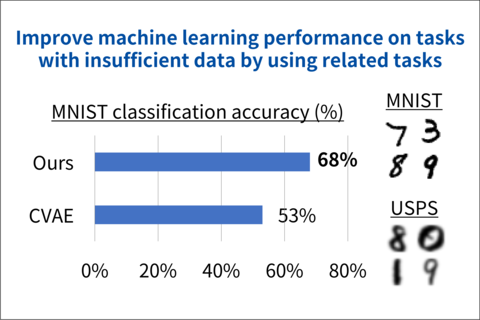

表現を学習する際に用いる事前知識に着目し、従来用いられていた単純な事前知識を、関連する他のタスクのデータから学習した事前知識に変更することで、より適切な表現を学習します。実験ではデータが数百個と少ない場合でも、機械学習の性能が最大15%も向上しました。 |

| めざす未来 |

本技術を用いて既存の自動車や工場などのデータから事前知識を獲得することで、開発中の自動車や新しい工場など、十分にデータが蓄積されていない状況でも適切な表現の学習が可能となり、高い精度での異常検知などが実現できるようになります。 |

[1] H.Takahashi, T.Iwata, A.Kumagai, S.Kanai, M.Yamada, Y.Yamanaka, H.Kashima, “Learning Optimal Priors for Task-Invariant Representations in Variational Autoencoders,” in Proceedings of the 28th ACM SIGKDD Conference on Knowledge Discovery and Data Mining, 2022.

高橋 大志(Hiroshi Takahashi)協創情報研究部 知能創発環境研究グループ