研究展示

| 02 |

みんなにとって公平な決め方、教えます因果関係に基づく一人一人にとって公平な分類器の学習

|

|---|

| どんな研究 |

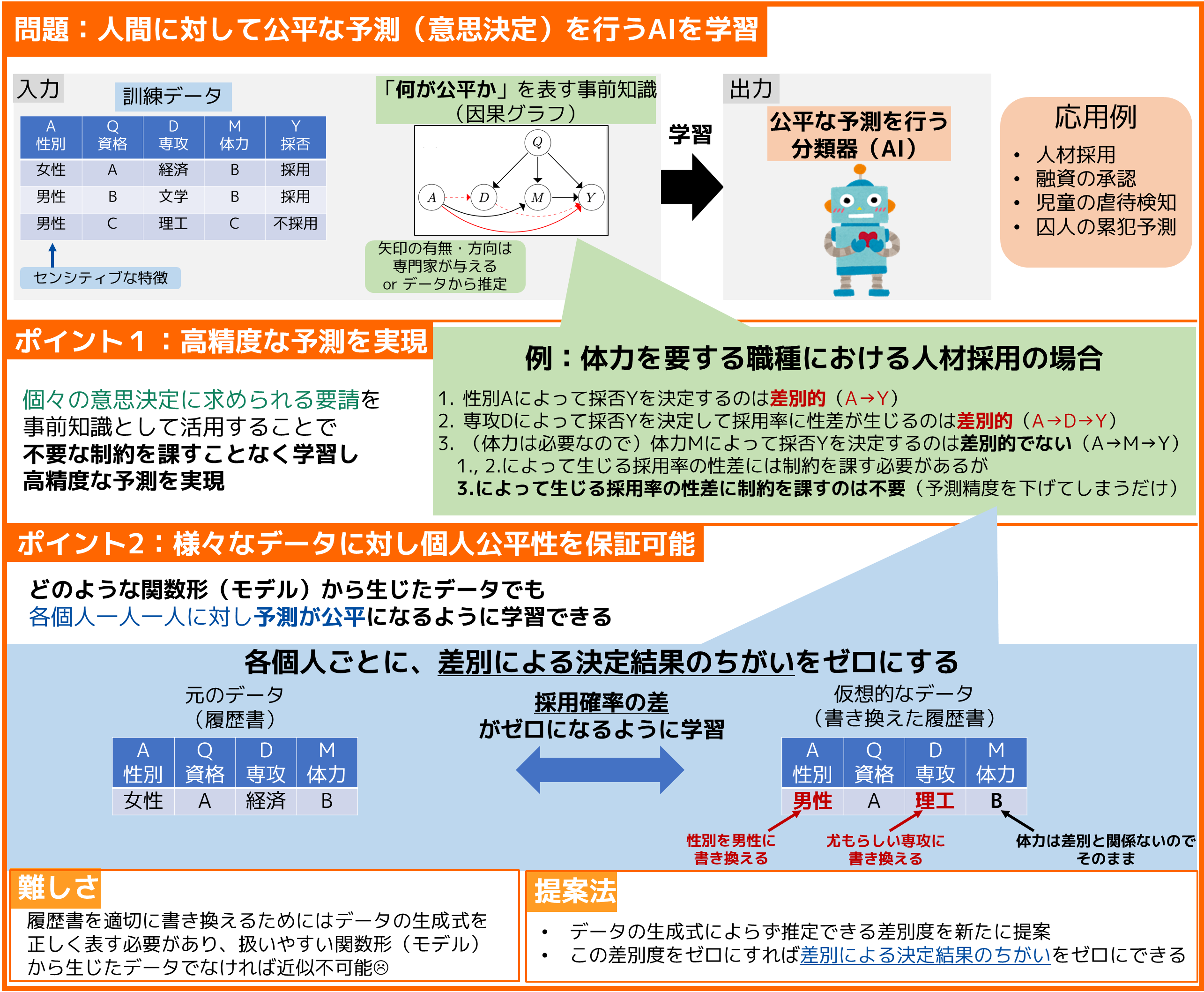

融資承認や人材採用、囚人の累犯予測など、人間に対する重大な意思決定を機械学習予測によって行うための研究です。この実現に向け、性別・人種・宗教・性的指向など、人間が持つセンシティブな特徴に関して公平で、かつ高精度な予測を行うための技術を考案しました。 |

|---|---|

| どこが凄い |

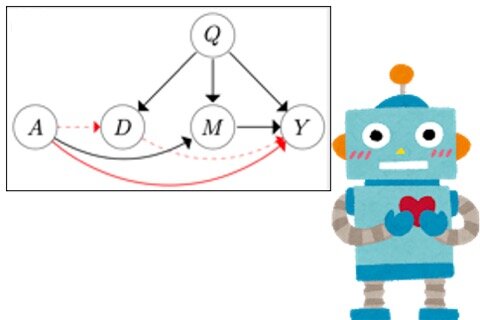

例えば「体力を要する職種なので体力が理由の不採用は差別的でない」といった要請に基づき、不要な制約なしに学習することで予測精度を高めます。従来法ではデータが特定のモデルから生じている場合のみ公平性を保証可能でしたが、提案法では様々なデータで公平性を保証できます。 |

| めざす未来 |

「何が公平か」は人や社会の価値観とともに移り変わるものです。社会的な要請と技術的な限界に向き合いながら、より柔軟に社会的要請に応じられる機械学習技術を実現し、一人一人が不利益を被ることなく、同時に、効率的な意思決定を行える社会に貢献できればと考えています。 |

[1] Y. Chikahara, S. Sakaue, A. Fujino, H. Kashima, “Learning Individually Fair Classifier with Path-Specific Causal-Effect Constraint,” in Proc. the 24-th International Conference on Artificial Intelligence and Statistics (AISTATS), 2021.

動画の公開は終了いたしました。ご了承くださいますようお願いいたします。

Q&A の公開は終了いたしました。ご了承くださいますようお願いいたします。

近原 鷹一 (Yoichi Chikahara) 協創情報研究部 知能創発環境研究グループ

Email: cs-openhouse-ml@hco.ntt.co.jp